منو

[ASRating]

یکی از اولین مواردی که هنگام کار بر روی سئو سایت باید بررسی و بهینه سازی کنید ، فایل robots.txt است. مشکل یا پیکربندی نادرست درفایل robots.txt شما می تواند مشکلات سئو مهمی را ایجاد کند که می تواند بر رتبه و ترافیک شما تأثیر منفی بگذارد.

در این مقاله که از سری مقاله های مربوط به سئو تکنیکال است ، شما خواهید آموخت که فایل robots.txt چیست ، چرا به آن احتیاج دارید ، چگونه آن را بهینه سازی کنیم و چگونه می توان آزمایش کرد که موتورهای جستجو بدون هیچ مشکلی به آن دسترسی پیدا کنند.

اگر از وردپرس استفاده می کنید ، در انتهای این مقاله ، اطلاعات خاصی در مورد فایل مجازی وردپرس robots.txt وجود دارد.

robots.txt یک فایل متنی است که در فهرست اصلی وب سایت شما قرار دارد و به موتورهای جستجوگر دستور می دهد که در هنگام خزیدن و نمایه سازی در کدام صفحات می توانند خزیده وآن را فهرست بندی کنند.

در مرحله خزیدن و نمایه سازی ، موتورهای جستجو سعی می کنند صفحات موجود در وب عمومی را پیدا کنند تا بتوانند در فهرست خود قرار دهند.

هنگام بازدید از یک وب سایت ، اولین کاری که آنها انجام می دهند این است که محتویات فایل robots.txt را جستجو و بررسی کنند.

بسته به قوانین مشخص شده در فایل ، آنها لیستی از URL هایی را که می توانند خزیده شوند ایجاد کرده و بعدا برای وب سایت خاص فهرست بندی می کنند.

محتویات robots.txt به صورت عمومی در اینترنت در دسترس است. مگر اینکه به گونه دیگری محافظت شود . هر کس می تواند فایل robots.txt شما را ببیند. بنابراین این فایل برای افزودن محتوایی نیست که نمی خواهید دیگران ببینند.

اگر یک فایل robots.txt وجود نداشته باشد ، خزنده های موتور جستجو فرض می کنند که می توانند همه صفحات عمومی وب سایت را خزیده و به فهرست خود اضافه کنند.

بستگی به موضوع دارد. اگر موتورهای جستجو نتوانند محتویات فایل را به دلیل پیکربندی نادرست درک کنند ، همچنان به وب سایت دسترسی خواهند داشت و هر آنچه در robots.txt وجود دارد را نادیده می گیرند.

این مشکل بزرگی است برای شروع ، آنها صفحات وب سایت شما را نمی خزند و فهرست نمی کنند و به تدریج صفحاتی را که در فهرست آنها موجود است حذف می کنند.

بله ، شما قطعاً باید فایل robots.txt داشته باشید . حتی اگر نمی خواهید هیچ صفحه یا فهرست وب سایت خود را از نمایش در نتایج موتورهای جستجو حذف کنید.

رایج ترین موارد استفاده از robots.txt موارد زیر است:

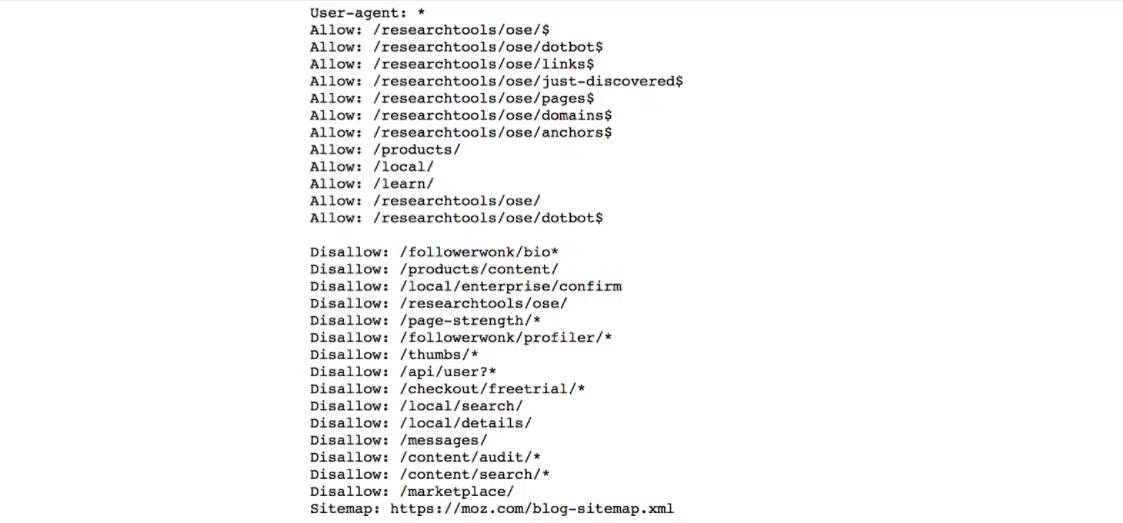

برای جلوگیری از دسترسی موتورهای جستجو به صفحات یا فهرستهای وب سایت شما. برای مثال ، به robots.txt زیر نگاه کنید و به قوانین ممنوعیت توجه کنید.

این جملات به خزنده های موتورهای جستجو دستور می دهد که فهرست های خاصی را فهرست بندی نکنند. توجه داشته باشید که می توانید از * به عنوان یک کاراکتر مرجع استفاده کنید.

وقتی یک وب سایت بزرگ دارید ، خزیدن و نمایه سازی می تواند یک فرایند بسیار پیچیده باشد. خزنده های موتورهای جستجوی مختلف سعی می کنند کل سایت شما را خزیده و فهرست بندی کنند و این می تواند مشکلات جدی در عملکرد سایت شما ایجاد کند.

در این حالت ، می توانید از robots.txt استفاده کنید تا دسترسی به بخشهایی از وب سایت خود را که برای خدمات سئو یا رتبه بندی مهم نیستند ، محدود کنید. به این ترتیب ، شما نه تنها بار سرور خود را کاهش می دهید ، بلکه کل روند نمایه سازی را سریعتر می کند.

هنگامی که تصمیم می گیرید از پوشش آدرس تان(URL cloaking) برای لینک های افیلیت (همکاری در فروش) خود استفاده کنید. این مانند پوشاندن محتوا یا URL های شما برای فریب کاربران یا موتورهای جستجو نیست ، بلکه یک فرایند معتبر برای سهولت مدیریت لینک های افیلیت شما است.

اولین نکته این است که هر قانونی که به robots.txt اضافه می کنید ، دستورالعمل است. این بدان معناست که موتورهای جستجو باید اطاعت کرده و قوانین را رعایت کنند.

نکته دوم این است که حتی اگر یک صفحه یا فهرست را در روبات ها مسدود کنید ، اگر لینک هایی از صفحات دیگر که قبلاً فهرست بندی شده اند داشته باشد ، همچنان در نتایج جستجو ظاهر می شود. به عبارت دیگر ، افزودن یک صفحه به robots.txt تضمین نمی کند که آن صفحه حذف شود یا در وب ظاهر نشود.

علاوه بر محافظت از صفحه یا فهرست از رمز عبور ، راه دیگر استفاده از دستورالعمل های صفحه است. به هر صفحه اضافه می شود و مانند مثال زیر است:

<meta name=”robots” content=”noindex”>

فایل روبات ها ساختار بسیار ساده ای دارد. برخی از کلیدواژه ها و ترکیب های با ارزش از پیش تعیین شده وجود دارد که می توانید از آنها استفاده کنید.

رایج ترین آنها عبارتند از User-agent ، Disallow ، Allow ، Crawl-delay ، Sitemap

User-agent: مشخص می کند که کدام خزنده ها باید دستورالعمل ها را در نظر بگیرند. می توانید از یک * برای مرجع همه خزنده ها یا تعیین نام یک خزنده استفاده کنید ، به مثالهای زیر مراجعه کنید.

می توانید همه نام ها و مقادیر موجود برای دستور user-agent را اینجا مشاهده کنید.

* :User-agent شامل همه کراولرها میشود.

User-agent: Googlebot دستور العمل فقط برای ربات های گوگل

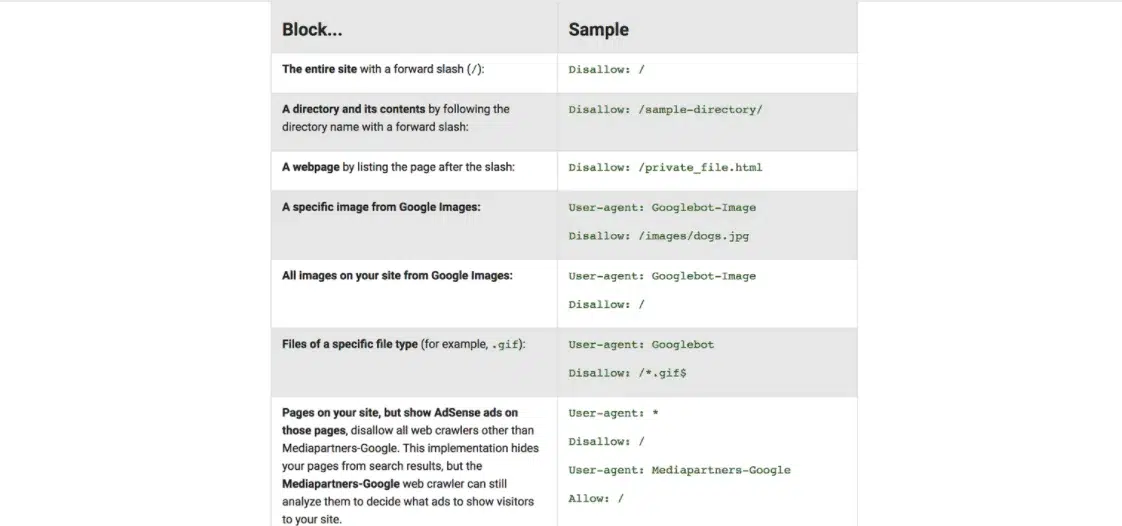

Disallow : دستورالعملی که به user-agent دستور می دهد (در بالا مشخص شده است) ، نشانی وب یا بخشی از وب سایت را نخزد.

مقدار disallow می تواند یک فایل ، آدرس اینترنتی یا دایرکتوری خاص باشد. به مثال زیر نگاه کنید که از پشتیبانی گوگل گرفته شده است.

Allow : دستورالعملی که به صراحت به صفحات یا زیر پوشه ها می تواند دسترسی پیدا کند. این فقط برای Googlebot قابل اجرا است.

شما می توانید از اجازه برای دسترسی به یک زیر پوشه خاص در وب سایت خود استفاده کنید ، حتی اگر فهرست اصلی ممنوع باشد.

به عنوان مثال ، می توانید دسترسی به فهرست عکس های خود را ممنوع کنید ، اما اجازه دسترسی به زیر پوشه آیفون خود را که در قسمت عکس ها قرار دارد ، بدهید.

User-agent: *

Disallow: /photos

Allow: /photos/iphone/

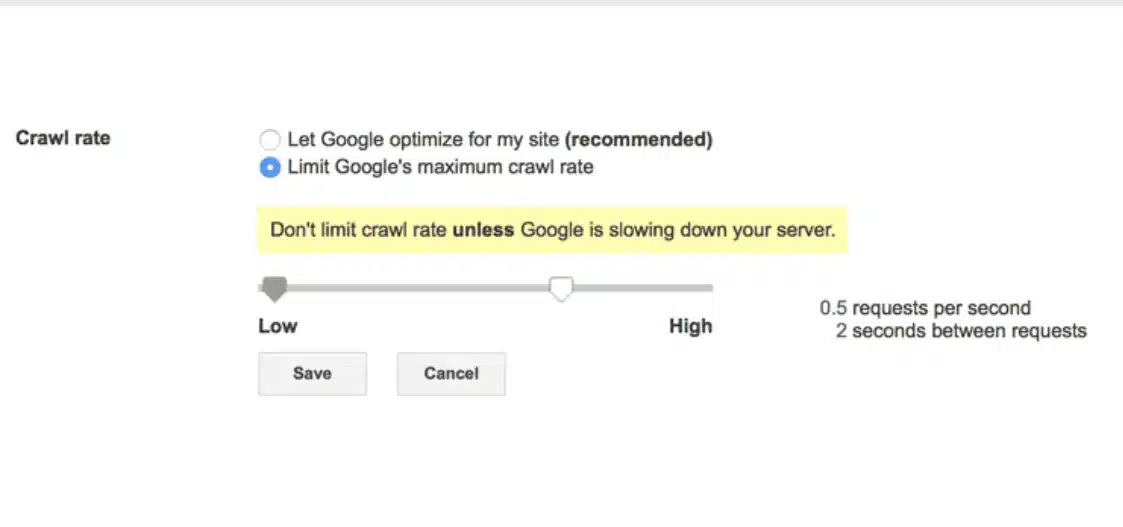

Crawl-delay: می توانید مقدار تاخیر خزیدن را مشخص کنید تا خزنده های موتور جستجو را مجبور کنند تا مدت زمان خاصی منتظر بمانند تا صفحه بعدی وب سایت شما خزیده شود. مقدار وارد شده بر حسب میلی ثانیه است.

لازم به ذکر است که تاخیر خزیدن توسط Googlebot در نظر گرفته نمی شود.

برای کنترل بودجه خزیدن برای گوگل می توانید از گوگل سرچ کنسول در این قسمت استفاده کنید .

در مواردی که وب سایتی با هزاران صفحه دارید و نمی خواهید سرور خود را با درخواست های مستمر بارگیری کنید ، می توانید از سرعت خزیدن استفاده کنید.

در اکثر موارد ، شما نباید از دستورالعمل تاخیر در خزیدن استفاده کنید.

نقشه سایت (Site map): دستورالعمل نقشه سایت توسط موتورهای جستجوی اصلی از جمله گوگل پشتیبانی می شود و از آن برای تعیین محل نقشه سایت XML شما استفاده می شود.

حتی اگر مکان نقشه سایت XML را در روبات ها مشخص نکنید ، موتورهای جستجو همچنان قادر به یافتن آن هستند.

به عنوان مثال ، می توانید از این استفاده کنید:

Sitemap: https://example.com/sitemap.xml

مهم: Robots.txt به حروف کوچک و بزرگ حساس است. این بدان معناست که اگر این دستورالعمل Disallow: /File.html را اضافه کنید ، file.html را مسدود نمی کند.

ایجاد یک فایل robots.txt آسان است. تنها چیزی که نیاز دارید یک ویرایشگر متن (مانند براکت یا دفترچه یادداشت) و دسترسی به (پرونده های وب سایت شما ) از طریق FTP یا کنترل پنل است.

قبل از وارد شدن به فرآیند ایجاد یک فایل ربات ، اولین کاری که باید انجام دهید این است که بررسی کنید آیا قبلاً یک پرونده دارید یا خیر.

ساده ترین راه برای انجام این کار این است که یک پنجره جدید مرورگر باز کنید و به آدرس https://www.yourdomain.com/robots.txt بروید.

اگر چیزی شبیه به تصویر زیر مشاهده کردید ، به این معنی است که شما قبلاً یک فایل robots.txt دارید و می توانید به جای ایجاد یک فایل جدید ، فایل موجود را ویرایش کنید.

User-agent: *

Allow: /

از سرویس گیرنده FTP مورد علاقه خود استفاده کرده و به فهرست اصلی وب سایت خود متصل شوید.

Robots.txt همیشه در پوشه اصلی (Root folder) بسته به سرور شما (www یا public_html ) قرار دارد.

فایل را روی رایانه خود بارگیری کرده و با ویرایشگر متن باز کنید.

تغییرات لازم را انجام دهید و فایل را دوباره در سرور خود بارگذاری کنید.

اگر قبلاً robots.txt ندارید ، یک فایل txt. جدید با استفاده از ویرایشگر متن ایجاد کنید ، دستورالعمل های خود را اضافه کنید ، آن را ذخیره کرده و در فهرست اصلی وب سایت خود بارگذاری کنید.

مهم: مطمئن شوید که نام فایل شما robots.txt است و نه چیز دیگری باشد. همچنین ، به خاطر داشته باشید که نام فایل به حروف کوچک و بزرگ حساس است ، بنابراین باید همه آنها کوچک باشند.

robots.txt همیشه باید در صفحه اصلی وب سایت شما و نه درپوشه ای دیگر باشد.

در یک سناریوی معمولی ، فایل robots.txt شما باید دارای محتویات زیر باشد:

User-agent: *

Allow: /

Sitemap: https://example.com/sitemap.xml

این به همه ربات ها اجازه می دهد بدون هیچ گونه مسدودی ، به وب سایت شما دسترسی پیدا کنند. همچنین مکان نقشه سایت را مشخص می کند تا مکان یابی آن برای موتورهای جستجو آسان تر شود.

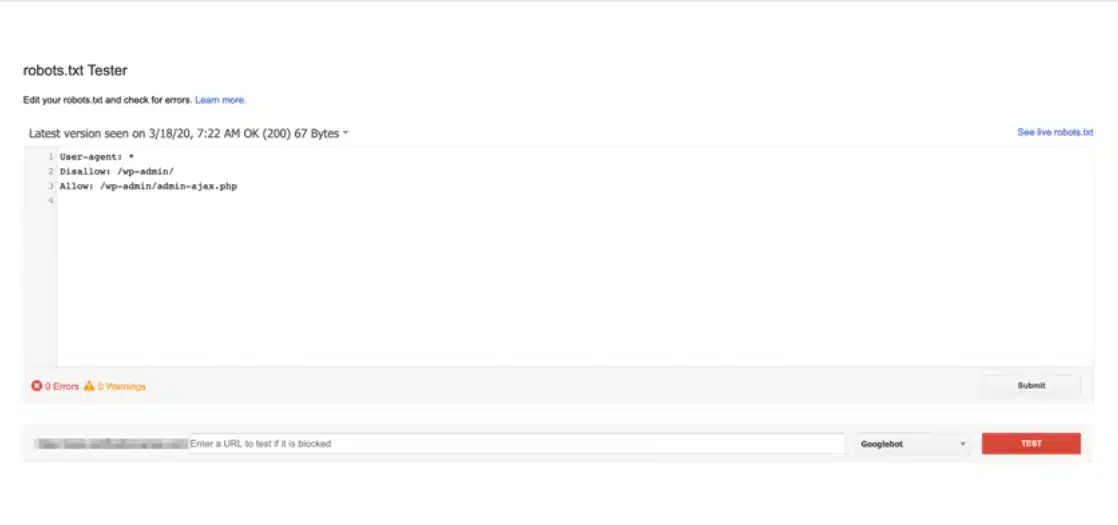

در حالی که می توانید محتویات robots.txt خود را با رفتن به آدرس robots.txt مشاهده کنید ، بهترین راه برای آزمایش و تأیید آن از طریق ابزار robots.txt Tester سرچ کنسول گوگل است.

روی دکمه تست بزنید.

اگر همه چیز خوب باشد ، دکمه Test سبز می شود و برچسب مجاز (Allowed) می شود. اگر مشکلی وجود داشته باشد ، خطی که باعث عدم اجازه می شود مشخص می شود.

چند نکته دیگر که باید در مورد ابزار تست robots.txt بدانید:

می توانید از URL Tester (پایین ابزار) برای وارد کردن URL از وب سایت خود استفاده کنید و بررسی کنید که آیا مسدود شده است یا خیر.

شما می توانید هر گونه تغییری در ویرایشگر ایجاد کنید و قوانین جدید را بررسی کنید اما برای اینکه این قوانین در Robot.txt شما به طور زنده اجرا شود. باید فایل خود را با ویرایشگر متن ویرایش کرده و فایل را در پوشه اصلی وب سایت خود بارگذاری کنید.(همانطور که در بالا توضیح داده شد )

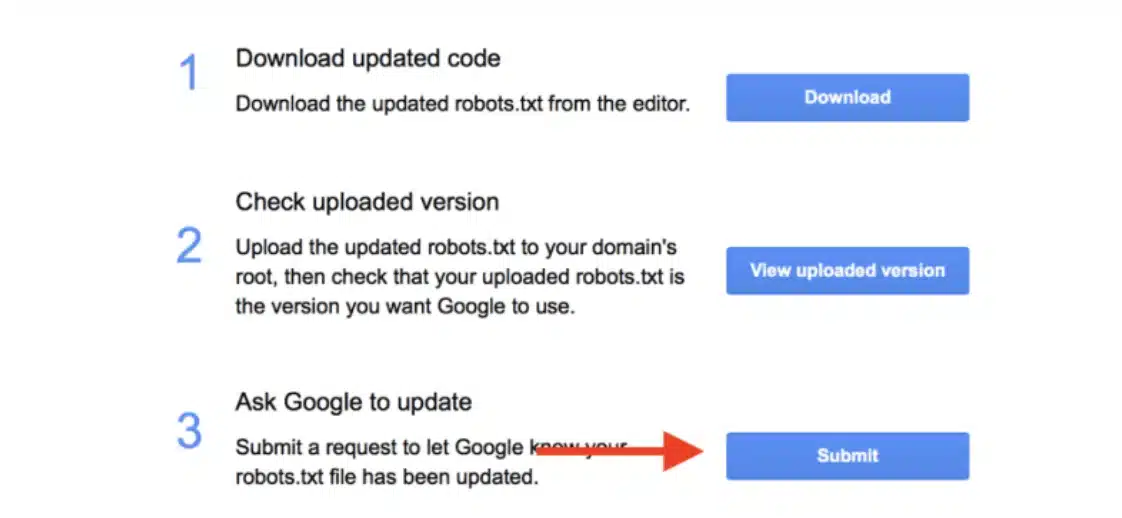

برای اطلاع به گوگل از تغییراتی که در robots.txt خود ایجاد کرده اید ، روی دکمه SUBMIT (از صفحه بالا) کلیک کنید و دوباره از پنجره پاپ آپ روی دکمه SUBMIT کلیک کنید. (گزینه ۳ همانطور که در زیر نشان داده شده است)

هر آنچه که تاکنون در مورد robots.txt خوانده اید برای وب سایت های وردپرس نیز قابل اجرا است.

تنها مواردی که باید در مورد robots.txt و WordPress بدانید موارد زیر است:

در گذشته ، به وب سایت های وردپرسی توصیه می شد که دسترسی به پوشه های wp-admin و wp-include را از طریق robots.txt مسدود کنند.

از سال ۲۰۱۲ این مورد دیگر مورد نیاز نیست زیرا وردپرس یک تگ را ارائه میدهد که کار مشابهی با Disallow در فایل Robot.txt انجام میدهد.

@header( 'X-Robots-Tag: noindex' );

وردپرس به طور پیش فرض از یک فایل robots.txt مجازی استفاده می کند. این بدان معناست که شما نمی توانید مستقیماً فایل را ویرایش کنید یا آن را در فهرست اصلی سایت خود پیدا کنید.

تنها راه مشاهده محتویات فایل این است که https://www.yourdomain.com/robots.txt را در مرورگر خود تایپ کنید.

مقادیر پیش فرض فایل Robot.txt در وردپرس به شکل زیر است:

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

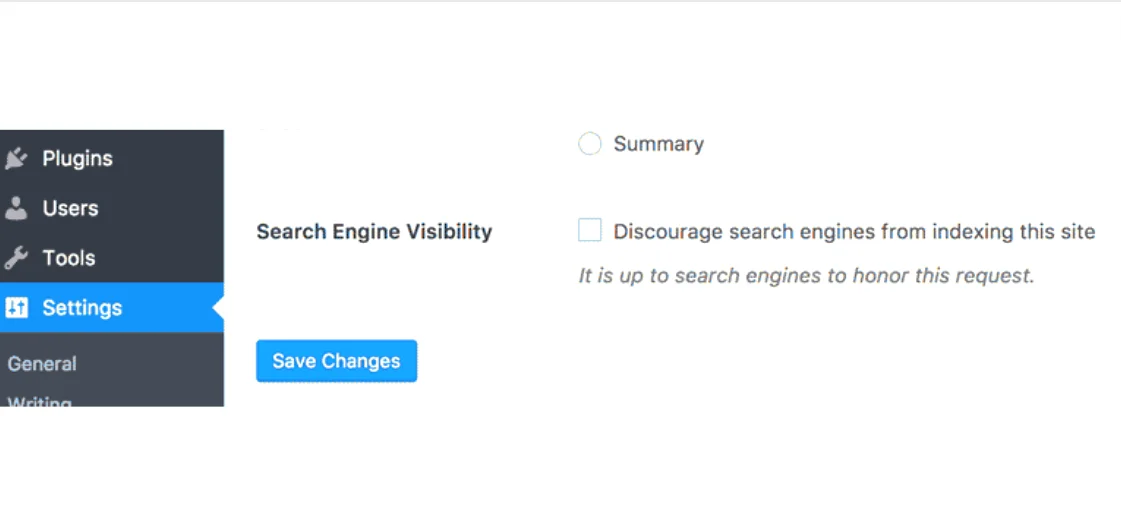

هنگامی که شما گزینه Discourage search engines from indexing this site را در قسمت Search Engine Visibility Settings فعال می کنید ، robots.txt به صورت زیر می شود:

User-agent: *

Disallow: /

این دستور اساساً دسترسی همه خزنده ها به وب سایت را مسدود می کند.

از آنجا که نمی توانید مستقیم فایل robots.txt مجازی ارائه شده توسط وردپرس را ویرایش کنید ، تنها راه ویرایش آن ایجاد یک فایل جدید و افزودن آن به فهرست اصلی وب سایت شما است.

هنگامی که یک فایل فیزیکی در فهرست اصلی وجود دارد ، فایل مجازی وردپرس در نظر گرفته نمی شود.

robots.txt خود را آزمایش کنید و مطمئن شوید که هیچ قسمتی از وب سایت خود را که می خواهید در موتورهای جستجو ظاهر شود مسدود نمی کنید.

پوشه های CSS یا JS را مسدود نکنید. گوگل در حین خزیدن و نمایه سازی می تواند یک وب سایت را مانند یک کاربر واقعی مشاهده کند و اگر صفحات شما برای عملکرد صحیح به JS و CSS نیاز دارند ، نباید مسدود شوند.

اگر از وردپرس استفاده می کنید ، نیازی به مسدود کردن دسترسی به پوشه های wp-admin و wp-include شما نیست. وردپرس با استفاده از برچسب meta robots کار خود را خوبی انجام می دهد.

سعی نکنید قوانین متفاوتی را برای هر ربات موتور جستجو تعیین کنید ، ممکن است گیج کننده و به روز نگه داشتن آن دشوار باشد. بهتر است از user-agent استفاده کنید:* و یک مجموعه قوانین برای همه ربات ها ارائه دهید.

اگر می خواهید صفحات ایندکس شده توسط موتورهای جستجو حذف شوند ، بهتر است این کار را با استفاده از سربرگ هر صفحه انجام دهید و نه از طریق robots.txt اقدام کنید.

نیازی نیست زمان زیادی را صرف پیکربندی یا آزمایش فایل Robot.txt خود کنید. مهم این است که یکی از آن داشته باشید و از طریق Google Webmaster Tools آزمایش کنید که آیا دسترسی خزنده های موتور جستجو به وب سایت شما را مسدود نمی کند. شما میتوانید این کار را از طریق مشاوره سئو از شرکت های سئو سایت انجام دهید.

این نکته ای است که باید برای اولین بار در هنگام ایجاد وب سایت خود یا به عنوان بخشی از برنامه سئو خود انجام دهید.

+ میتونی این مطلب رو با دوستات هم به اشتراک بذاری...

محتوای این بلاگ توسط کارشناسان تایید شده است.

با تشکر از شما برای زمانی که صرف مطالعه این نوشته کردید.

محمد امیری - کارشناس ارشد سئو نبض مارکتینگ

+ ممکنه به این مطالب هم علاقهمند شی...

+ میتونی دیدگاهت رو با بقیه به اشتراک بذاری...

دستهبندی مقالات