فایل robots.txt یکی از ابزارهای مهم در مدیریت دسترسی خزندههای وب به محتوای سایت است که به شما امکان میدهد تعیین کنید کدام صفحات یا بخشهای سایت شما قابل خزیدن و ایندکس شدن توسط موتورهای جستجو باشند. این فایل، که بهصورت یک فایل متنی ساده و با فرمت .txt در هاست سایت قرار میگیرد، به ویژه برای وبسایتهای وردپرسی از اهمیت بالایی برخوردار است.

استفاده از فایل robot.txt وردپرس میتواند به شما کمک کند تا عملکرد خزندهها را بهینه کنید و از خزیدن صفحات غیرضروری یا حساس جلوگیری کنید. در این مقاله، به بررسی نحوه عملکرد فایل robots.txt، محدودیتهای آن و روشهای ایجاد و بهینهسازی این فایل خواهیم پرداخت. همچنین نکات مهمی برای استفاده صحیح از این فایل در وبسایت و نقش آن در خدمات سئو را نیز مورد بحث قرار میدهیم.

فایل robots.txt چیست؟

فایل robots.txt یک فایل متنی ساده است که در دایرکتوری هاست وبسایت قرار میگیرد و به عنوان مجموعهای از دستورات برای رباتهای وب عمل میکند. برخی از این رباتها خوب و برخی بد هستند؛ رباتهای خوب مانند خزندههای وب برای ایندکس کردن محتوا و نمایش آن در نتایج موتورهای جستجو فعالیت میکنند.

فایل robots.txt شبیه به یک «دستورالعمل رفتاری» است که بر روی دیوار یک باشگاه ورزشی نصب شـده است. این تابلو قوانین را بیان میکند، اما خودش قدرت اجرای آنها را ندارد. افراد خوب قوانین را رعایت میکنند، در حالی که افراد بد ممکن است آنها را نقض کرده و جریمه شوند. فایل robots.txt نیز به رباتهای خوب مانند خزندههای وب دستور میدهد که چگونه و چه بخشهایی از وبسایت را میتوانند بازدید کنند، اما رباتهای بد احتمالاً این دستورات را نادیده میگیرند.

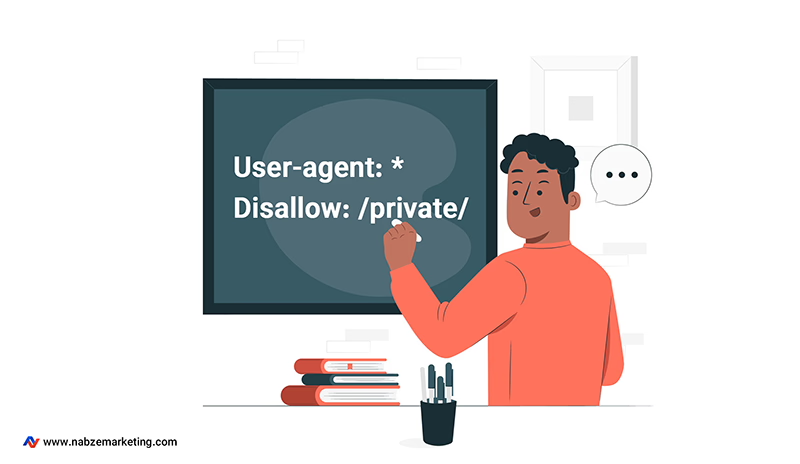

این فایل شامل یک یا چند قانون است که دسترسی رباتها به مسیرهای خاصی از دامنه یا زیر دامنه وبسایت را محدود یا مجاز میکند. در صورتی که چیزی در فایل robots.txt ذکر نشـده باشد، به طور پیشفرض، تمام فایلها برای خزیدن مجاز هستند. یک فایل ساده robots.txt ممکن است به شکل زیر باشد:

در این مثال:

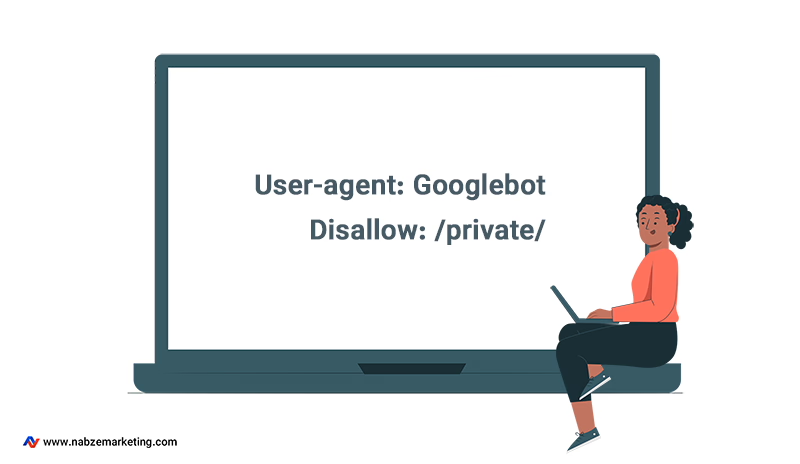

User-agent: با استفاده از این خط میتوانید نوع رباتی که قوانین برای آن اعمال میشود را مشخص کنید (ستاره به معنای همه رباتهاست).

Disallow: این دستور به رباتها میگوید که نباید به مسیر مشخص شـده (در اینجا /private/) دسترسی داشتـه باشند.

این فایل ساده، ابزار قدرتمندی است که به صاحبان وبسایتها امکان کنترل و مدیریت بهتر رفتار خزندههای وب را میدهد و به بهبود عملکرد وبسایت در نتایج موتورهای جستجو کمک میکند.

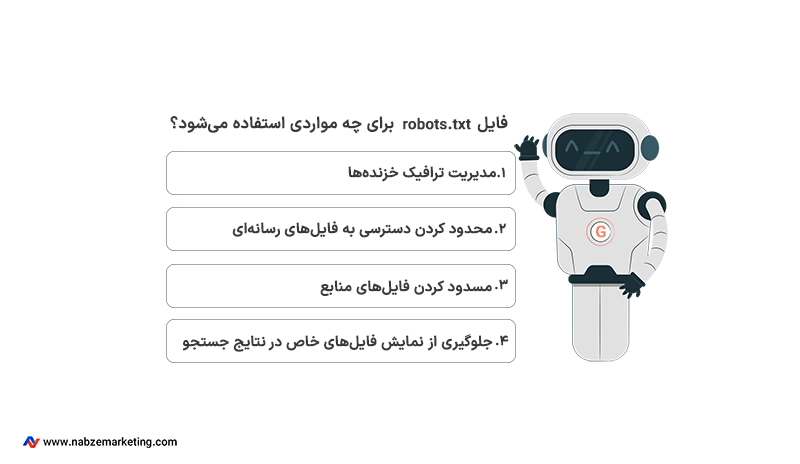

فایل robots.txt برای چه مواردی استفاده میشود؟

فایل robots.txt بهطور کلی به منظور جلوگیری از دسترسی رباتها به بخشهای خاصی از وبسایت استفاده میشود. در ادامه کاربردهای اصلی فایل robots.txt را توضیح میدهیم:

۱ – مدیریت ترافیک خزندهها با فایل robots.txt

یکی از اصلیترین کاربردهای فایل robots.txt، مدیریت ترافیک خزندهها به وبسایت است. این فایل به صاحبان وبسایت کمک میکند تا رفتار خزندهها را هدایت کنند و از وارد شدن بار اضافی بر سرور جلوگیری کنند. برای مثال، اگر سرور شما تحت فشار است و نمیخواهید که خزندههای گوگل ترافیک زیادی به آن وارد کنند، میتوانید دسترسی خزندهها را به برخی صفحات غیرضروری یا مشابه محدود کنید.

فایل robots.txt به شما امکان میدهد که دسترسی خزندهها به صفحاتی که اهمیت کمتری دارند یا محتوای مشابهی با صفحات دیگر دارند، مسدود کنید. این کار میتواند به بهبود بهرهوری سایت و مدیریت بودجه خزیدن (crawl budget) کمک کند.

۲ – محدود کردن دسترسی به فایلهای رسانهای

شما میتوانید از فایل robots.txt برای جلوگیری از خزیدن و نمایش فایلهای رسانهای مانند تصاویر، ویدیوها و فایلهای صوتی در نتایج جستجوی گوگل استفاده کنید. این کار به معنای جلوگیری از دسترسی کاربران به این فایلها نیست، بلکه فقط مانع از نمایش آنها در نتایج جستجوی موتورهای جستجو میشود.

۳ – مسدود کردن فایلهای منابع

اگر وبسایت شما شامل فایلهای منابع مانند تصاویر غیرضروری، اسکریپتها یا فایلهای استایل (CSS) است که تأثیری بر نمایش اصلی صفحه ندارند، میتوانید آنها را با استفاده از فایل robots.txt مسدود کنید. این کار به خزندهها کمک میکند که روی محتوای اصلی سایت تمرکز کنند. اما باید مراقب باشید که اگر مسدود کردن این منابع باعث شود که گوگل نتواند صفحه را به درستی درک کند، بهتر است این منابع را مسدود نکنید.

۴ – جلوگیری از نمایش فایلهای خاص در نتایج جستجو

این فایل به شما کمک میکند تا از نمایش فایلهای خاص مانند PDFها یا دیگر فایلهای غیر HTML در نتایج جستجو جلوگیری کنید. اگر نمیخواهید یک فایل خاص در نتایج جستجوی گوگل نمایش داده شود، میتوانید دسترسی خزندهها را به آن فایل مسدود کنید. با این حال، این روش تضمینی برای جلوگیری کامل از نمایش فایل در نتایج جستجو نیست و بهتر است از روشهای دیگر مانند تگ noindex یا حفاظت با رمز عبور استفاده کنید.

نکات مهم در استفاده از فایل robots.txt

۱ – عدم استفاده برای مخفی کردن صفحات وب

استفاده از فایل robots.txt برای مخفی کردن صفحات وب (مانند فایلهای PDF و دیگر فرمتهای متنی) از نتایج جستجوی گوگل توصیه نمیشود. اگر سایر صفحات به صفحه شما لینک دهند، ممکن است آدرس URL آن صفحه همچنان در نتایج جستجو ظاهر شود. اگر میخواهید به طور کامل از نمایش یک صفحه در نتایج جستجو جلوگیری کنید، از روشهای دیگری مانند تگ noindex یا حفاظت با رمز عبور استفاده کنید.

۲ – مسدود کردن منابع مهم ممنوع است

اگر مسدود کردن منابعی مانند تصاویر، اسکریپتها یا فایلهای CSS باعث شود که گوگل نتواند محتوای صفحه را به درستی درک کند، از این کار خودداری کنید، زیرا این کار میتواند بر روی نحوه نمایش و تحلیل محتوای سایت شما توسط گوگل تأثیر منفی بگذارد.

فایل robots.txt ابزاری مفید برای مدیریت دسترسی رباتهای وب به سایت است، اما باید با درک دقیق از محدودیتها و کاربردهای آن استفاده شود تا به بهبود عملکرد سایت شما کمک کند.

نحوه عملکرد فایل robots.txt چگونه است؟

فایل ربات یک فایل متنی ساده با فرمت .txt است که هیچ کد HTML در آن وجود ندارد. این فایل در سرور وبسایت میزبانی میشود و میتوان آن را مانند هر فایل دیگری از طریق مرورگر مشاهده کرد. برای دسترسی به این فایل کافی است آدرس اصلی وبسایت را وارد کرده و سپس “/robots.txt” را به انتهای آن اضافه کنید، مثلاً: https://www.example.com/robots.txt. این فایل معمولاً بهطور مستقیم در بخشهای مختلف وبسایت لینک نمیشود، بنابراین کاربران بهطور عادی به آن دسترسی پیدا نمیکنند، اما رباتهای خزنده وب، قبل از خزیدن در سایر صفحات سایت، ابتدا این فایل را بررسی میکنند. در ادامه به نحوه عملکرد رباتها با فایل robots.txt خواهیم پرداخت:

۱ – چک کردن قوانین قبل از خزیدن

هنگامی که یک ربات خزنده (مانند گوگلبات) به یک وبسایت میرسد، اولین کاری که انجام میدهد این است که فایل robots.txt را جستجو و مطالعه کند. این فایل به رباتها دستور میدهد که کدام بخشهای وبسایت را میتوانند یا نمیتوانند بازدید کنند. اگر ربات دستوراتی پیدا کند که دسترسی به بخشی از سایت را منع کرده باشد، از آن قسمت صرفنظر کرده و بقیه سایت را بازدید میکند.

۲ – اجرای دستورات به صورت داوطلبانه

فایل robots.txt توانایی اعمال دستورات خود را بهصورت اجباری ندارد؛ بلکه رباتهای «خوب» مانند خزندههای موتورهای جستجو به این دستورات پایبند هستند و آنها را رعایت میکنند. اما رباتهای «بد» ممکن است این دستورات را نادیده بگیرند و حتی از آنها برای پیدا کردن صفحات ممنوعه استفاده کنند.

۳ – اولویت با دستورات خاص

اگر در فایل robots.txt دستورات متناقضی وجود داشتـه باشد، ربات خزنده از دستوری پیروی میکند که دقیقتر و جزئیتر باشد. به عنوان مثال، اگر یک دستور کلی به ربات اجازه دهد که کل وبسایت را خزیده و ایندکس کند، اما یک دستور خاص دسترسی به یک بخش مشخص را منع کند، ربات از دستور خاص پیروی خواهد کرد.

۴ – نیاز به فایل جداگانه برای زیر دامنهها

هر ساب دامین از وبسایت به فایل robots.txt مخصوص خود نیاز دارد. به عنوان مثال، اگر وبسایت اصلی شما یک فایل robots.txt دارد، زیر دامنههای آن (مانند blog.example.com) نیز به فایلهای robots.txt مجزا نیاز خواهند داشت.

چگونه فایل robots.txt ایجاد کنیم؟

ایجاد فایل robots.txt یکی از مهمترین بخشهای مدیریت یک وبسایت است، زیرا به شما این امکان را میدهد که دسترسی رباتهای موتورهای جستجو را به بخشهای مختلف سایت خود کنترل کنید. این فایل بهصورت مجموعهای از قوانین نوشتـه میشود که به خزندهها میگوید کدام بخشها را میتوانند کراول و ایندکس کنند. در ادامه، مراحل ایجاد فایل robots.txt و نحوه نوشتن قوانین آن را توضیح میدهیم:

۱ – ایجاد فایل متنی ساده

ابتدا یک فایل متنی ساده با فرمت .txt در ویرایشگر متنی مانند Notepad یا Notepad++ ایجاد کنید. نام این فایل باید دقیقاً robots.txt باشد.

۲ – نوشتن قوانین (Directives)

فایل robots.txt شامل یک یا چند گروه از قوانین است. هر گروه با دستور User-agent شروع میشود و مشخص میکند که این گروه قوانین برای کدام ربات (خزنده) اعمال میشود. سپس، دستورات Disallow و Allow برای مشخص کردن دسترسی به صفحات یا پوشهها استفاده میشوند.

ساختار کلی یک گروه از قوانین به شکل زیر است:

User-agent

مشخص میکند که دستورات به کدام خزنده اعمال میشوند. برای مثال، User-agent: * به معنای اعمال قوانین برای همه خزندهها است. همچنین میتوانید نام خزنده خاصی مانند Googlebot را مشخص کنید.

Disallow

مسیر یا فایلی را که نمیخواهید خزنده به آن دسترسی داشتـه باشد، مشخص میکند. این دستور باید با / شروع شود و در صورت اشاره به یک پوشه، با / به پایان برسد.

Allow

در مواردی که یک مسیر فرعی را میخواهید از یک قانون Disallow مستثنی کنید، استفاده میشود.

۳ – افزودن نقشه سایت (اختیاری)

شما میتوانید مسیر نقشه سایت (sitemap) خود را نیز در فایل robots.txt قرار دهید تا به خزندهها نشان دهید کدام محتوا باید کراول شود. مثال:

۴ – مثالهای کاربردی از فایل robots.txt

در این بخش به کد های فایل robots.txt پر کاربرد میپردازیم:

۱ – مسدود کردن دسترسی همه خزندهها به کل وبسایت:

۲ – اجازه دسترسی به همه خزندهها به کل وبسایت:

۳ – مسدود کردن دسترسی Googlebot به پوشه خاصی:

۴ – مسدود کردن همه خزندهها به همه فایلهای .php:

نکات مهم در ایجاد فایل robots.txt

حساس به حروف بزرگ و کوچک: دستورات در فایل robots.txt به حروف بزرگ و کوچک حساس هستند. برای مثال، Disallow: /file.asp با /FILE.asp متفاوت است.

استفاده از کاراکتر # برای توضیحات: هر چیزی که بعد از # نوشتـه شود، بهعنوان توضیح در نظر گرفتـه میشود و در پردازش نادیده گرفتـه میشود.

آپلود فایل به سرور: پس از ایجاد و ذخیره فایل، آن را به دایرکتوری ریشه سایت خود آپلود کنید. برای مثال، باید به آدرس https://www.example.com/robots.txt قابل دسترسی باشد.

۵ – آزمایش و ارسال فایل robots.txt به گوگل

برای اطمینان از صحت فایل، میتوانید آن را در مرورگر به صورت خصوصی باز کنید و بررسی کنید که بهدرستی نمایش داده میشود. همچنین، ابزارهای تست فایل robots.txt در Google Search Console وجود دارد که به شما امکان میدهد فایل را قبل از استفاده آزمایش کنید.

پس از آپلود و آزمایش، گوگل بهصورت خودکار فایل robots.txt را شناسایی و استفاده میکند. اگر تغییراتی ایجاد کردید و میخواهید گوگل سریعتر فایل بهروزرسانیشـده را شناسایی کند، میتوانید فایل جدید را از طریق Google Search Console ارسال کنید.

محدودیتهای فایل robots.txt

با وجود کاربردهای مفید، فایل robots.txt دارای محدودیتهایی است که قبل از ایجاد یا ویرایش آن باید به آنها توجه کنید. بستـه به اهداف و شرایط شما، ممکن است نیاز باشد از روشهای دیگری برای جلوگیری از دیده شدن URLهای وبسایت خود در نتایج جستجو استفاده کنید.

۱ – عدم تضمین اجرای دستورات

دستورات موجود در فایل robots.txt بهعنوان رهنمودهای پیشنهادی برای رباتها هستند و نمیتوانند بهطور اجباری رفتار آنها را کنترل کنند. رعایت این دستورات کاملاً به خود ربات بستگی دارد. خزندههای معتبر مانند گوگلبات و بینگبات معمولاً این دستورات را رعایت میکنند، اما رباتهای مخرب ممکن است این دستورات را نادیده بگیرند. برای حفاظت از محتوای حساس یا خصوصی، بهتر است از روشهای امنیتی دیگری مانند محافظت از فایلها با رمز عبور استفاده کنید.

۲ – پشتیبانی محدود توسط موتورهای جستجو

همه موتورهای جستجو بهطور کامل از دستورات فایل robots.txt پشتیبانی نمیکنند. رباتهای مختلف ممکن است نحوه عملکرد متفاوتی در تفسیر دستورات داشتـه باشند، بنابراین ضروری است که از سینتکس مناسب برای هر ربات استفاده شود. رباتهای مختلف ممکن است برخی از دستورات را به شیوههای متفاوت تفسیر کنند یا اصلاً آنها را نادیده بگیرند.

۳ – امکان ایندکس شدن صفحات ممنوعه

یکی از محدودیتهای مهم فایل robots.txt این است که حتی اگر دسترسی به صفحهای را برای رباتها مسدود کنید، آن صفحه ممکن است همچنان در نتایج جستجو ظاهر شود. اگر صفحهای که در فایل robots.txt مسدود شـده از سایر سایتها لینک شـده باشد، موتورهای جستجو میتوانند آدرس URL آن را کشف و ایندکس کنند. در این حالت، ممکن است فقط آدرس URL و اطلاعات عمومی مثل متن لینکها در نتایج جستجو نمایش داده شود، حتی اگر محتوای صفحه ایندکس نشود.

برای جلوگیری کامل از نمایش صفحات در نتایج جستجو، باید از روشهای دیگری مانند استفاده از متا تگ نوایندکس (noindex)، هدرهای پاسخدهی noindex، محافظت با رمز عبور یا حذف کامل صفحه استفاده کنید.

۴ – پشتیبانی نشدن دستور noindex در فایل robots.txt

دستورات noindex که بهطور مستقیم در فایل robots.txt استفاده میشوند، توسط موتورهای جستجو مانند گوگل پشتیبانی نمیشوند. برای جلوگیری از ایندکس شدن صفحات، نباید به فایل robots.txt بهعنوان راهکاری برای جلوگیری از نمایش محتوا در نتایج جستجو اعتماد کنید. بهجای آن، استفاده از تگهای noindex در صفحه یا هدرهای HTTP مناسب توصیه میشود.

آنچه در این مقاله گفتیم

در پایان، میتوان گفت که robots.txt یک فایل ضروری برای هر وبسایتی است که به دنبال بهبود دسترسی و مدیریت رفتار خزندههای وب است. با استفاده صحیح از این فایل، میتوانید بهینهسازی سایت خود را بهبود بخشید، دسترسی به بخشهای حساس را محدود کنید و در نهایت عملکرد وبسایت خود را در موتورهای جستجو بهینه کنید. هرچند این فایل محدودیتهایی دارد، اما با آگاهی از این محدودیتها و استفاده از روشهای تکمیلی مانند تگهای noindex و حفاظت با رمز عبور، میتوان به نتایج بهتری دست یافت.

جان مولر (John Mueller)، تحلیلگر ارشد وبمستر در گوگل دراینباره میگوید: «robots.txt یک ابزار قدرتمند است، اما همیشه باید به یاد داشتـه باشید که این فایل نمیتواند بهتنهایی از ایندکس شدن محتوای شما جلوگیری کند. برای حفاظت کامل از محتوای سایت خود، باید از روشهای ترکیبی و جامع استفاده کنید.»

استفاده از فایل robots.txt به همراه سایر روشهای بهینهسازی میتواند نقش مهمی در خدمات سئو ایفا کند و به شما کمک کند تا سایت خود را به بهترین شکل ممکن در مقابل رباتهای موتورهای جستجو مدیریت کنید.

نوشتـه شـده در تیم تحریریه نبض مارکتینگ

شاید برای شما هم سوال باشد

۱ – فایل robots.txt در کجا آپلود میشود؟

فایل robots.txt باید در دایرکتوری هاست وبسایت شما آپلود شود، به طوری که به راحتی از طریق آدرس https://www.example.com/robots.txt قابل دسترسی باشد. این مکان به خزندههای وب اجازه میدهد تا قبل از بازدید از صفحات دیگر، این فایل را بررسی کرده و دستورات موجود را اجرا کنند.

۲ – فایل robots.txt وردپرس چیست؟

فایل robots.txt وردپرس همانند هر سایت دیگری عمل میکند و به رباتهای موتورهای جستجو میگوید کدام بخشهای سایت وردپرسی باید خزیده شوند. در وردپرس، میتوان این فایل را به صورت دستی ایجاد کرد یا از افزونههایی مانند Yoast SEO برای مدیریت آن استفاده کرد.

۳ – چگونه میتوان فایل robots.txt را ویرایش کرد؟

برای ویرایش فایل robot.txt میتوانید از یک ویرایشگر متنی ساده مانند Notepad استفاده کنید. پس از ایجاد تغییرات، فایل را ذخیره کرده و آن را دوباره به دایرکتوری ریشه وبسایت آپلود کنید. در وردپرس نیز افزونههایی مانند Yoast SEO امکان ویرایش این فایل را مستقیماً از پیشخوان سایت فراهم میکنند.

۴ – آیا استفاده از فایل robots.txt برای سئو ضروری است؟

استفاده از فایل robots.txt میتواند به بهبود سئو سایت کمک کند، اما ضروری نیست. این فایل به شما کمک میکند تا خزیدن رباتها در سایت خود را مدیریت کنید و از ایندکس شدن صفحات غیرضروری جلوگیری کنید. با این حال، نباید از آن بهعنوان تنها روش جلوگیری از ایندکس شدن محتوا استفاده شود و باید به همراه دیگر تکنیکهای سئو به کار گرفتـه شود.