در حوزه وب و سئو، اصطلاحاتی مانند «کراول» و «خزش سایت» به وفور به کار میروند. این فرآیندها برای موتورهای جستجو به منظور شناسایی، ایندکس و رتبهبندی صفحات وبسایتها ضروری هستند. اما کراول چیست و چرا برای عملکرد بهتر سایت شما مهم است؟ در این مقاله به بررسی مفهوم کراول، اهمیت آن در خدمات سئو و نحوه بهینهسازی خزش سایت توسط کراولرهای گوگل خواهیم پرداخت.

کراول چیست؟

کراول یا خزش فرآیندی است که در آن موتورهای جستجو از طریق نرمافزارهای خودکار به نام کراولر یا ربات، صفحات وبسایتها را اسکن میکنند. کراولرها از طریق لینکها به صفحات جدید میرسند، محتوای آنها را میخوانند و اطلاعات جمعآوری شده را ایندکس میکنند. به عبارت سادهتر، کراولر مثل یک کتابدار است که تمام صفحات دنیای وب را بررسی و فهرست میکند تا کاربران بتوانند بهراحتی به محتوای مورد نظرشان دسترسی پیدا کنند.

نقش کراولر گوگل در خزش سایت

کراولرهای گوگل یا به اصطلاح “ربات گوگل” مهمترین ابزارهای گوگل برای جمعآوری اطلاعات از وب هستند. این رباتها به طور مداوم در حال جستجو و خزش سایتهای مختلف هستند و محتوای جدید یا بهروز شده را میخوانند. اگر صفحات وب به درستی crawl نشوند، ممکن است اطلاعات آنها در ایندکس گوگل قرار نگیرد، که این موضوع به شدت بر رتبهبندی سایت در صفحه نتایج جستجو(SERP) تأثیر میگذارد.

چطور کراول سایت را بهینه کنیم؟

برای بهینهسازی فرآیند crawl سایت توسط رباتهای موتورهای جستجو باید چندین عامل مهم را در نظر بگیرید. این بهینهسازی باعث میشود که رباتهای جستجو راحتتر و سریعتر محتوای سایت شما را خزش کرده و آن را ایندکس کنند که در نهایت به بهبود رتبه کلمات کلیدی سایت در نتایج جستجو کمک میکند. در ادامه، روشهای اصلی بهینهسازی کراول سایت را توضیح میدهیم:

۱. استفاده از ساختار مناسب سایت

سایت شما باید دارای ساختار منظم و بهینه باشد تا رباتهای کراولر بتوانند به راحتی بین صفحات مختلف حرکت کنند. طراحی ساختار سلسلهمراتبی و دستهبندی صحیح محتوای سایت به کراولرها کمک میکند تا صفحات مهم را سریعتر پیدا کنند.

۲. نقشه سایت (XML Sitemap)

نقشه سایت به موتورهای جستجو کمک میکند تا به سرعت به فهرست صفحات مهم وبسایت شما دسترسی پیدا کنند. این فایل شامل لینکهای داخلی به تمام صفحات حیاتی سایت است و رباتهای موتورهای جستجو از آن برای خزش موثرتر استفاده میکنند. میتوانید نقشه سایت خود را از طریق سرچ کنسول به گوگل معرفی کنید تا فرآیند خزش بهبود یابد.

۳. بهینهسازی فایل Robots.txt

فایل robots.txt مشخص میکند که رباتهای جستجو به کدام بخشهای سایت شما دسترسی داشته باشند و کدام صفحات نباید کراول شوند. مدیریت صحیح این فایل میتواند از خزش بیهوده صفحاتی که برای ایندکس شدن مناسب نیستند جلوگیری کرده و بودجه خزش را به صفحات مهمتر اختصاص دهد.

۴. سرعت بارگذاری صفحات

سرعت بارگذاری صفحات تأثیر زیادی بر فرآیند کراول دارد. سایتهایی که سریعتر بارگذاری میشوند، شانس بیشتری برای خزش مکرر دارند و زودتر ایندکس میشوند. بنابراین بهینهسازی تصاویر، فشردهسازی فایلها و استفاده از CDN (شبکه تحویل محتوا) میتواند به افزایش سرعت سایت کمک کند و کراولرها را به خزش بیشتر ترغیب کند.

۵. لینکهای داخلی مناسب

استفاده صحیح از لینکهای داخلی باعث میشود که کراولرها بتوانند به صفحات بیشتری دسترسی پیدا کنند. ایجاد لینکهای داخلی بین صفحات مرتبط یکی از بهترین روشها برای هدایت کراولرها به محتوای مهم و جدید سایت است.

۶. بهروزرسانی منظم محتوا

کراولرهای موتورهای جستجو به محتوای بهروز و تازه علاقه دارند. بهروزرسانی منظم محتوای قدیمی یا افزودن محتوای جدید باعث میشود رباتها بیشتر به سایت شما مراجعه کنند و در نتیجه خزش بیشتری انجام شود. محتوای تازه به بهبود رتبهبندی سایت کمک میکند.

۷. پرهیز از خطاهای خزش (Crawl Errors)

اطمینان از رفع خطاهای خزش مانند خطای ۴۰۴ و خطاهای سرور بسیار مهم است. این خطاها میتوانند باعث متوقف شدن فرآیند خزش رباتها و عدم ایندکس صفحات مهم شوند. میتوانید با استفاده از ابزارهایی مثل گوگل سرچ کنسول این خطاها را شناسایی و رفع کنید.

نحوه عملکرد کراولر گوگل

گوگل کراولر بخشی از سیستم گوگل برای کشف، جمعآوری و ایندکس محتوای وب است. این فرآیند به گوگل کمک میکند تا صفحات وب جدید را شناسایی کرده و تغییرات صفحات موجود را بهروزرسانی کند. در ادامه، نحوه عملکرد کراولر گوگل را بهطور دقیقتر بررسی میکنیم:

۱ – شروع با لیست URLها

فرآیند خزش گوگل با یک لیست از URLهایی که قبلاً ایندکس شدهاند یا به عنوان URL جدید معرفی شدهاند، آغاز میشود. این لیست شامل صفحاتی است که یا از طریق نقشه سایت (XML Sitemap) ارسال شدهاند یا از طریق لینکهای خارجی و داخلی کشف شدهاند.

۲ – خزش صفحات

خزنده گوگل به سراغ لیست URLها رفته و شروع به اسکن صفحات میکند. در این مرحله، گوگل خزش محتوای صفحه، لینکها، تصاویر، فایلهای جاوا اسکریپت و سایر منابع را بررسی میکند. این خزش به کمک رباتهای خودکار انجام میشود که صفحات را مانند یک مرورگر وب باز میکنند اما بدون تعامل انسانی.

۳ – تحلیل لینکها

در فرآیند خزش، گوگل کراولر تمام لینکهای داخلی و خارجی موجود در صفحه را بررسی میکند. لینکها به عنوان مسیرهایی برای دسترسی به محتوای جدید عمل میکنند، به همین دلیل خزنده گوگل از آنها برای کشف صفحات جدید استفاده میکند. هرچه لینکهای داخلی به درستی تنظیم شده باشند، صفحات بیشتری توسط گوگل شناسایی و ایندکس میشوند.

۴ – پردازش و جمعآوری اطلاعات

پس از خزش، گوگل اطلاعات جمعآوری شده را پردازش میکند. این اطلاعات شامل بررسی محتوای متنی، تصاویر، متا تگ ها و سایر عناصر مهم سئو است. در این مرحله، الگوریتمهای گوگل محتوای صفحه را تحلیل میکنند تا ارتباط موضوعی، کیفیت محتوا و دیگر فاکتورهای رتبهبندی را ارزیابی کنند.

۵ – ایندکس صفحات

پس از پردازش، گوگل تصمیم میگیرد که آیا صفحه باید ایندکس شود یا نه. اگر صفحه دارای محتوای باکیفیت و منطبق با سیاستهای گوگل باشد، ایندکس میشود. ایندکس شدن صفحات به گوگل اجازه میدهد تا در زمان جستجوی کاربران، صفحات مناسب را به نمایش بگذارد. صفحات ایندکسشده بر اساس معیارهای مختلفی مانند کیفیت محتوا، سرعت بارگذاری و بهینهسازی برای موبایل رتبهبندی میشوند.

۶ – بهروزرسانی مستمر

گوگل کراولر بهطور مداوم به سایتها بازمیگردد تا محتوای جدید یا تغییرات در محتوای موجود را شناسایی کند. این بهروزرسانی مداوم برای حفظ دقت و بهروز بودن نتایج جستجو ضروری است. سایتهایی که بهطور منظم بهروزرسانی میشوند یا محتوای جدید اضافه میکنند، بیشتر مورد توجه گوگل کراولر قرار میگیرند.

انواع خطاهای خزش سایت

خطاهای crawl به مشکلاتی اشاره دارند که گوگل کراولرها در هنگام خزش و ایندکس صفحات وب با آنها مواجه میشوند. این خطاها مانع از دسترسی کراولرها به محتوای سایت میشوند و میتوانند بر رتبهبندی سایت در نتایج جستجوی گوگل تأثیر منفی بگذارند. آگاهی از این خطاها و رفع آنها برای بهینهسازی سایت ضروری است. در ادامه مهمترین انواع خطاهای کراول را بررسی میکنیم:

۱ – خطای DNS

این خطاها زمانی رخ میدهند که گوگل کراولر نتواند به سرور سایت متصل شود. خطاهای DNS به دلایلی مثل مشکل در تنظیمات سرور، نام دامنه نادرست یا زمان پاسخگویی طولانی سرور رخ میدهند. این خطاها مانع از خزش کراولرها در سایت میشوند.

۲ – خطای سرور (Server Error)

این خطاها معمولاً به دلیل مشکلات در سرور سایت رخ میدهند، مانند سرورهای غیرقابل دسترس، زمان پاسخ طولانی یا مشکلات پیکربندی سرور. این خطاها معمولاً بهصورت کد وضعیت HTTP 500 یا ۵۰۳ نشان داده میشوند و بیانگر این است که سرور قادر به پردازش درخواست crawler نیست.

۳ – خطای Not Found (خطای ۴۰۴)

این خطاها زمانی رخ میدهند که صفحهای که کراولر گوگل به دنبال آن است وجود نداشته باشد یا حذف شده باشد. خطاهای ۴۰۴ میتوانند تجربه کاربری و اعتبار سایت را تحت تأثیر قرار دهند و در صورت زیاد بودن تعداد آنها، عملکرد crawl سایت کاهش مییابد.

۴ – خطای ریدایرکت

خطاهای ریدایرکت معمولاً به دلیل تنظیمات نادرست ریدایرکتها به وجود میآیند. برای مثال، ریدایرکتهای زنجیرهای (چندین ریدایرکت پشت سر هم) یا ریدایرکتهای حلقهای (ریدایرکتهایی که به خودشان بازمیگردند) میتوانند کراولرها را سردرگم کرده و مانع از دسترسی آنها به محتوای نهایی شوند.

۵ – خطای Robots.txt

این خطا زمانی رخ میدهد که فایل robots.txt بهدرستی تنظیم نشده باشد و به اشتباه دسترسی کراولرها به صفحات مهم سایت مسدود شود. فایل robots.txt به کراولرها اعلام میکند کدام بخشهای سایت را نباید خزش کنند، اما اگر به اشتباه صفحات مهم بلاک شوند، آن صفحات ایندکس نخواهند شد.

۶ – خطاهای URL مسدود شده توسط Noindex

این خطا زمانی رخ میدهد که تگ نوایندکس در صفحات سایت بهکار رفته باشد. این تگها به گوگل اعلام میکنند که نباید این صفحات را ایندکس کند. اگر به اشتباه در صفحات مهم از این تگ استفاده شود، آن صفحات در نتایج جستجو ظاهر نخواهند شد.

۷ – خطاهای دسترسی (Access Denied)

این خطاها زمانی رخ میدهند که کراولرها به دلیل تنظیمات نادرست سطح دسترسی (مانند نیاز به لاگین یا محدودیتهای IP) نتوانند به صفحات سایت دسترسی پیدا کنند. برای مثال، صفحاتی که نیاز به ورود با رمز عبور دارند یا دسترسی آنها محدود به IPهای خاص است، معمولاً با این خطاها مواجه میشوند.

چگونه خطاهای کراول را شناسایی و رفع کنیم؟

برای شناسایی این خطاها میتوان از ابزارهایی مانند گوگل سرچ کنسول (Google Search Console) استفاده کرد. این ابزار گزارشهای دقیقی از خطاهای خزش ارائه میدهد و به شما کمک میکند که مشکلات را بهسرعت شناسایی و رفع کنید. برای رفع خطاها میتوان با بهبود تنظیمات سرور، اصلاح لینکهای شکسته، بهروزرسانی فایل robots.txt و اطمینان از صحت ریدایرکتها اقدام کرد.

گوگل چطور متوجه میشود که باید صفحه شما را خزش کند؟

گوگل برای شناسایی و خزش سایت از ترکیبی از روشها و سیگنالها استفاده میکند. هدف اصلی این است که محتوای جدید و بهروزرسانیهای صفحات موجود را کشف کند تا نتایج جستجو بهروز و دقیق باشند. در ادامه، روشهایی که گوگل از طریق آنها تصمیم میگیرد کدام صفحات را خزش کند، شرح داده شده است:

۱ – استفاده از لینکها

یکی از اصلیترین راههای کشف صفحات جدید توسط گوگل، لینکها هستند. وقتی یک صفحه خزش میشود، گوگل کراولر تمام لینکهای موجود در آن صفحه را بررسی میکند و از آنها برای کشف صفحات جدید استفاده میکند. این لینکها شامل لینکهای داخلی و لینکهای خارجی است. بنابراین، وجود لینکهای داخلی منظم و بکلینکهای باکیفیت میتواند به کشف و خزش صفحات شما کمک کند.

۲ – نقشه سایت (XML Sitemap)

نقشه سایت یک فایل XML است که شامل فهرستی از تمام صفحات مهم وبسایت شماست. این فایل به گوگل اطلاعات دقیقی درباره ساختار سایت و صفحات موجود میدهد. وقتی شما نقشه سایت خود را در گوگل سرچ کنسول ثبت میکنید، به گوگل کمک میکنید که صفحات جدید یا بهروزرسانیها را راحتتر و سریعتر شناسایی کند.

۳ – گوگل سرچ کنسول

از طریق این ابزار، شما میتوانید مستقیماً از گوگل درخواست کنید که صفحات خاصی را خزش کند. این قابلیت بهخصوص زمانی که یک صفحه جدید ایجاد کردهاید یا تغییرات مهمی در صفحات موجود دادهاید، بسیار مفید است. همچنین، میتوانید صفحات مشکلدار را بررسی کرده و درخواست خزش مجدد آنها را ثبت کنید.

۴ – فایل Robots.txt

این فایل به گوگل کراولر اعلام میکند که کدام صفحات را میتواند خزش کند و کدام صفحات را نباید بررسی کند. اگر صفحات خاصی را برای خزش مجاز بگذارید و دسترسی به آنها را مسدود نکنید، گوگل میتواند بهراحتی آنها را خزش کند. اما در صورت وجود دستورات نادرست در این فایل، ممکن است صفحات مهم شما crawl نشوند.

۵ – تگهای متا و هدرهای HTTP

استفاده از تگهای متا مانند <meta name=”robots” content=”index, follow”> به گوگل اطلاع میدهد که صفحه شما باید ایندکس شود و لینکهای موجود در آن باید خزش شوند. همچنین، هدرهای HTTP اطلاعاتی مانند ریدایرکتها یا تغییرات در محتوای صفحه به کراولرها میدهند.

۶ – بهروزرسانی محتوا

گوگل کراولر به صفحات پرمحتوا و بهروزرسانی شده علاقه دارد. اگر یک صفحه بهطور منظم بهروزرسانی شود یا محتوای جدیدی به آن اضافه شود، گوگل آن را به عنوان صفحهای فعال شناسایی کرده و بیشتر به خزش آن ترغیب میشود. صفحات قدیمی ممکن است کمتر توسط کراولرها بازدید شوند.

۷ – رفتار کاربران

رفتار کاربران نیز میتواند گوگل را به سمت صفحات خاصی هدایت کند. برای مثال، اگر کاربران زیادی به صفحه شما از طریق جستجو یا لینکهای خارجی دسترسی پیدا کنند، گوگل متوجه اهمیت آن صفحه شده و ممکن است آن را بیشتر خزش کند.

۸ – سیگنالهای شبکههای اجتماعی

هرچند گوگل بهطور مستقیم سیگنالهای شبکههای اجتماعی مانند لایکها و اشتراکگذاریها را به عنوان فاکتور رتبهبندی استفاده نمیکند، اما این سیگنالها میتوانند به کشف صفحات جدید کمک کنند. لینکهای به اشتراک گذاشته شده در شبکههای اجتماعی میتوانند به عنوان ورودیهایی برای کراولرها عمل کنند.

بودجه خزش چیست؟

بودجه خزش به تعداد صفحاتی اطلاق میشود که گوگل کراولر میتواند و میخواهد در یک دوره زمانی مشخص در سایت شما خزش کند. این بودجه به عوامل مختلفی مانند سرعت پاسخگویی سرور و اهمیت صفحات بستگی دارد و بهینهسازی آن به بهبود عملکرد سئو کمک میکند.

روشهای جلوگیری از خزش سایت

گاهی اوقات ممکن است بخواهید از خزش برخی از صفحات سایت توسط موتورهای جستجو جلوگیری کنید. این میتواند به دلیل حفاظت از اطلاعات حساس، جلوگیری از خزش محتوای تکراری یا بهبود بودجه خزش سایت باشد. در ادامه، روشهای مختلف برای جلوگیری از خزش صفحات وب را توضیح میدهیم:

۱ – فایل Robots.txt

این فایل یکی از رایجترین روشها برای کنترل دسترسی کراولرها به صفحات مختلف سایت است. با استفاده از دستورات در فایل robots.txt، میتوانید به رباتهای موتورهای جستجو بگویید که کدام صفحات را نباید خزش کنند. بهعنوان مثال، دستور Disallow: /private-page/ باعث میشود کراولرها از خزش صفحهی خاصی جلوگیری کنند. با این حال، توجه داشته باشید که این روش کاملاً مانع ایندکس شدن صفحه نمیشود، زیرا برخی رباتها ممکن است این فایل را نادیده بگیرند.

۲ – تگ متا Robots

با افزودن تگ متا robots به کد HTML صفحات میتوانید به موتورهای جستجو دستور دهید که صفحه را خزش نکنند. بهعنوان مثال، تگ <meta name=”robots” content=”noindex, nofollow”> به رباتها میگوید که صفحه را ایندکس نکنند و لینکهای موجود در آن را دنبال نکنند. این روش بسیار مطمئنتر از robots.txt است و بهطور مستقیم در صفحه قرار میگیرد.

۳ – استفاده از هدرهای HTTP

میتوان از هدرهای HTTP برای جلوگیری از خزش صفحات استفاده کرد. با ارسال هدر X-Robots-Tag: noindex, nofollow در پاسخ سرور، میتوانید به رباتها اعلام کنید که نباید صفحه را ایندکس یا خزش کنند. این روش بهخصوص برای جلوگیری از خزش فایلهای غیر HTML مانند PDFها یا تصاویر مفید است.

۴ – حفاظت با رمز عبور

با قرار دادن صفحات در بخشهایی از سایت که نیاز به ورود با رمز عبور دارند، میتوانید از دسترسی رباتها به آن صفحات جلوگیری کنید. کراولرها نمیتوانند از این موانع عبور کنند، بنابراین صفحات محافظتشده خزش نمیشوند.

۵ – محدودیتهای دسترسی با IP یا کپچا

میتوانید دسترسی به صفحات را به آیپیهای خاص محدود کرده یا از سیستمهای کپچا استفاده کنید. این روشها مانع از دسترسی رباتها میشوند و برای محتوای حساس یا بخشهایی از سایت که نباید خزش شوند، مناسب هستند.

۶ – استفاده از جاوا اسکریپت برای مسدودسازی

با استفاده از جاوا اسکریپت میتوانید دسترسی به برخی از محتواها را برای کراولرها مسدود کنید، هرچند این روش مطمئن نیست و برخی کراولرهای پیشرفته میتوانند جاوا اسکریپت را اجرا کنند.

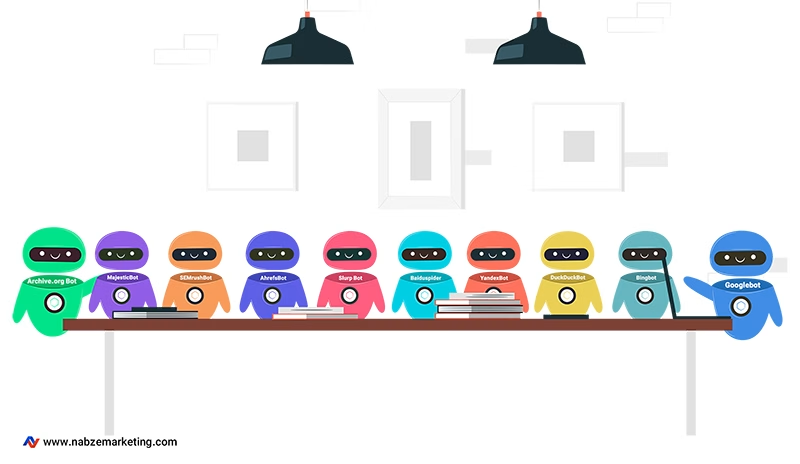

معرفی کراولرها

کراولرها انواع مختلفی دارند و هر کدام اهداف خاصی را دنبال میکنند و بسته به نیاز موتور جستجو یا ابزار، به جمعآوری اطلاعات مختلف از وبسایتها میپردازند. در ادامه انواع کراولرها را به شما معرفی میکنیم:

Googlebot: این خزنده اصلی گوگل است که صفحات وب را برای ایندکس و رتبهبندی در نتایج جستجو خزش میکند.

Bingbot: کراولر موتور جستجوی بینگ که وظیفه شناسایی و جمعآوری محتوای صفحات وب را برای ایندکس بینگ بر عهده دارد.

DuckDuckBot: خزنده موتور جستجوی DuckDuckGo که بدون ذخیره اطلاعات شخصی کاربران، صفحات وب را برای نتایج خود خزش میکند.

YandexBot: خزنده موتور جستجوی یاندکس که برای ایندکس و رتبهبندی صفحات در نتایج جستجوی یاندکس بهویژه در بازار روسیه استفاده میشود.

Baiduspider: کراولر اصلی موتور جستجوی بایدو که بر خزش و ایندکس وبسایتها برای کاربران چینی تمرکز دارد.

Slurp Bot: خزنده موتور جستجوی یاهو که محتوای وب را برای ایندکس در Yahoo Search خزش میکند.

AhrefsBot: یک کراولر تجاری که عمدتاً برای جمعآوری دادههای لینکها و سئو جهت استفاده در ابزارهای تحلیل لینک Ahrefs استفاده میشود.

SEMrushBot: خزنده ابزار SEMrush که برای تحلیل سئو، بررسی بکلینکها، و دادههای رقابتی وبسایتها خزش میکند.

MajesticBot: کراولر ابزار Majestic که بر روی جمعآوری دادههای مربوط به بکلینکها و تحلیل شبکههای لینک تمرکز دارد.

Archive.org Bot (Wayback Machine): کراولری که صفحات وب را برای ذخیره در آرشیو اینترنت و امکان مشاهده نسخههای قدیمی صفحات خزش میکند.

Video:How Google Search crawls pages

آنچه در این مقاله گفتیم…

این مقاله به توضیح مفهوم crawl (خزش) و اهمیت آن در بهینهسازی موتورهای جستجو (SEO) پرداختیم. کراول فرآیندی است که در آن رباتهای موتورهای جستجو صفحات وب را بررسی و ایندکس میکنند تا کاربران بتوانند به محتوای مرتبط دسترسی پیدا کنند. نقش مهم خزنده گوگل یا Googlebot در ایندکس و رتبهبندی صفحات وب، باعث شده که بهینهسازی این فرآیند برای سئو ضروری باشد.

بهینهسازی خزش شامل استفاده از ساختار مناسب سایت، نقشه سایت، بهبود سرعت بارگذاری صفحات و بهروزرسانی محتوای سایت است. همچنین در مورد خطاهای رایج crawl مانند خطاهای DNS، خطاهای سرور و خطاهای ۴۰۴ نیز گفتیم و روشهای جلوگیری از خزش ناخواسته صفحات، مانند استفاده از فایل robots.txt، تگهای متا و هدرهای HTTP را توضیح دادیم. در پایان، انواع کراولرهای معروف را نیز به شما معرفی کردیم.

نوشته شده در تیم تحریریه نبض مارکتینگ

شاید برای شما هم سوال باشد…

۱ – چرا خزش سایت برای سئو مهم است؟

خزش سایت توسط موتورهای جستجو به شناسایی و ایندکس صفحات سایت کمک میکند. اگر صفحات شما به درستی خزش نشوند، در نتایج جستجو ظاهر نمیشوند و این موضوع میتواند بر ترافیک و رتبهبندی سایت تأثیر منفی بگذارد. بنابراین، بهینهسازی خزش سایت یکی از اصول پایهای سئو است.

۲ – چه خطاهایی ممکن است در فرآیند خزش رخ دهد و چگونه میتوان آنها را رفع کرد؟

خطاهای رایج خزش شامل خطاهای DNS، سرور، ۴۰۴ و مشکلات مربوط به فایل robots.txt است. این خطاها معمولاً مانع دسترسی کراولرها به صفحات سایت میشوند. برای رفع این خطاها میتوان از ابزارهایی مانند گوگل سرچ کنسول استفاده کرد که به شناسایی و ارائه راهحل برای مشکلات خزش کمک میکند.

۳ – چگونه میتوان از خزش صفحات خاص توسط گوگل جلوگیری کرد؟

برای جلوگیری از خزش صفحات خاص، میتوان از فایل robots.txt استفاده کرد تا به رباتهای موتورهای جستجو بگویید که چه صفحاتی نباید خزش شوند. همچنین، استفاده از تگهای متا robots و هدرهای HTTP، حفاظت با رمز عبور و محدودیتهای دسترسی با IP میتواند به جلوگیری از خزش صفحات کمک کند.